NVIDIA GeForce RTX 4080 jest znacznie szybszy i bardziej energooszczędny od GeForce RTX 3080 - opublikowano pierwsze recenzje karty graficznej za 1199 dolarów

NVIDIA wreszcie zniosła swoje embargo i pozwoliła dedykowanym źródłom na publikację recenzji karty graficznej NVIDIA GeForce RTX 4080.

Co jest znane

Model generacji Ada Lovelace posiada 5nm układ AD103 z 9728 procesorami strumieniowymi i 76 rdzeniami najlepszego śladu. Posiada 16GB pamięci RAM (GDDR6X), 2,8GHz i przepustowość 22GB/s na pin. Całkowita przepustowość akceleratora wynosi 716,8 GB/s. NVIDIA oceniła nowy produkt na S1199. Jego poprzednik, GeForce RTX 699, ma cenę wywoławczą 699 dolarów.

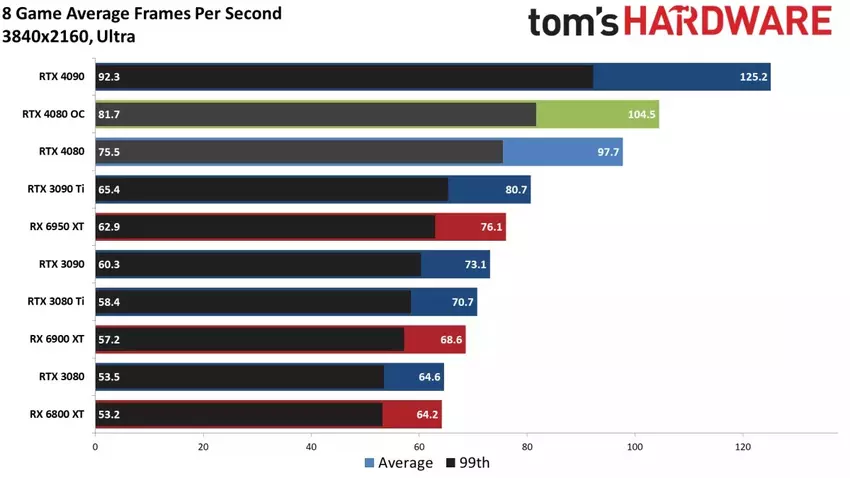

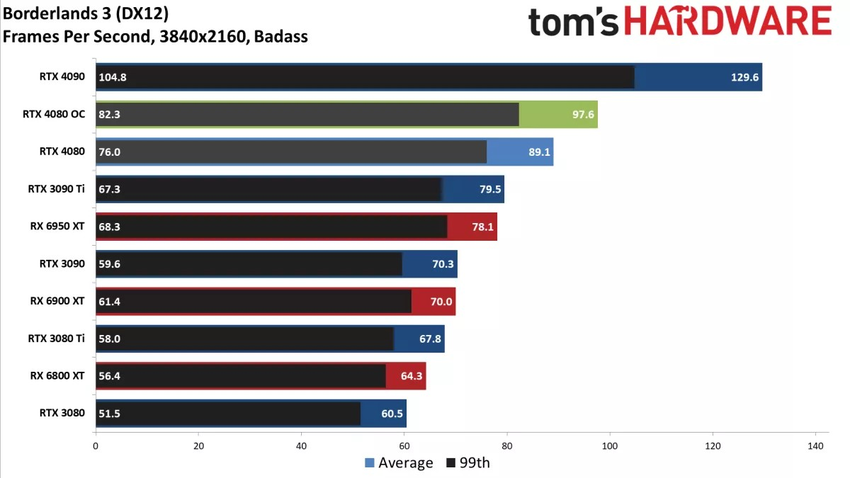

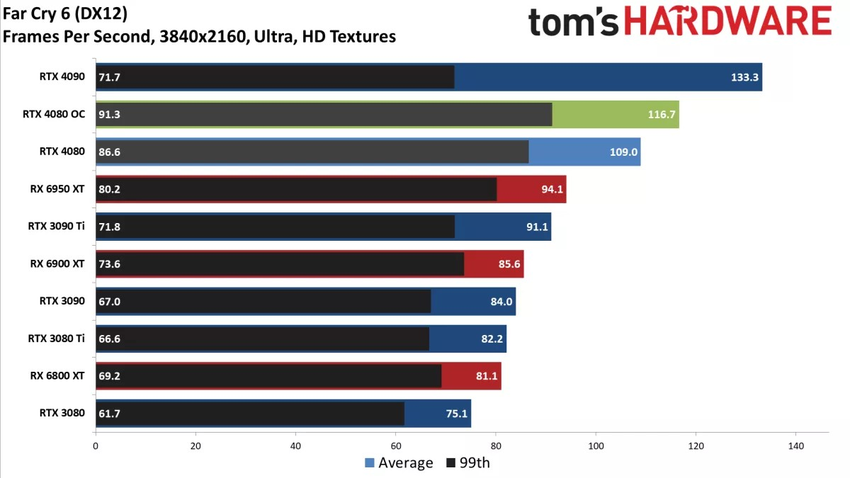

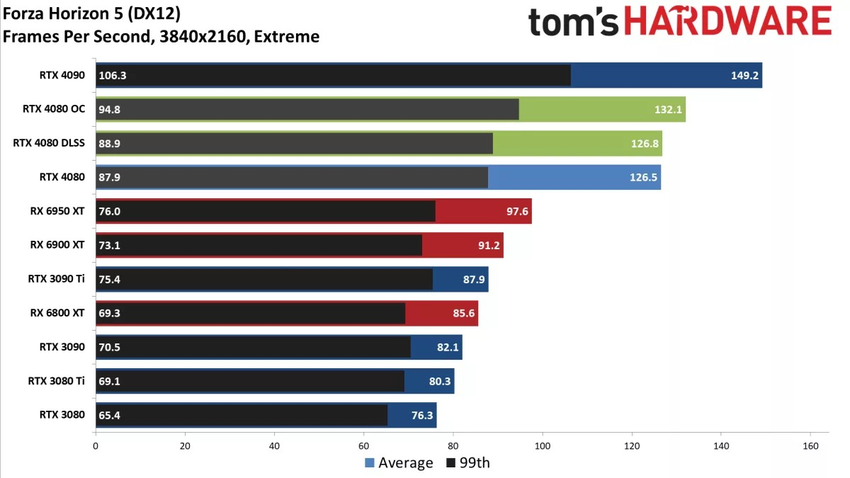

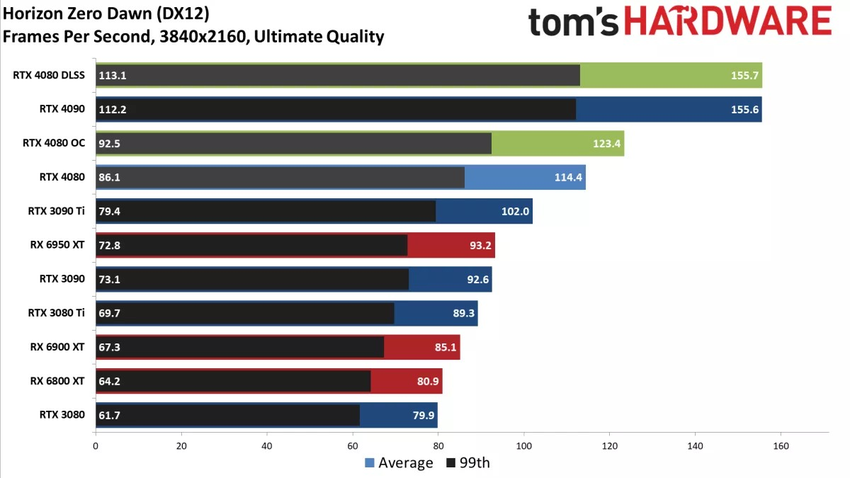

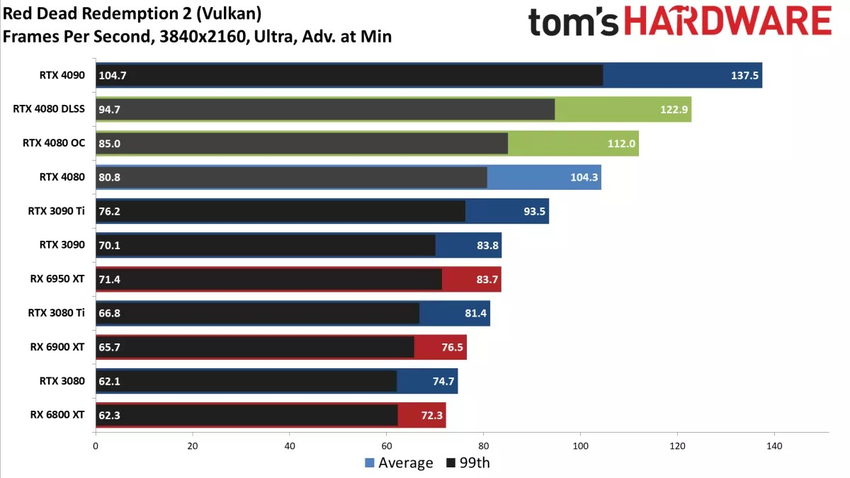

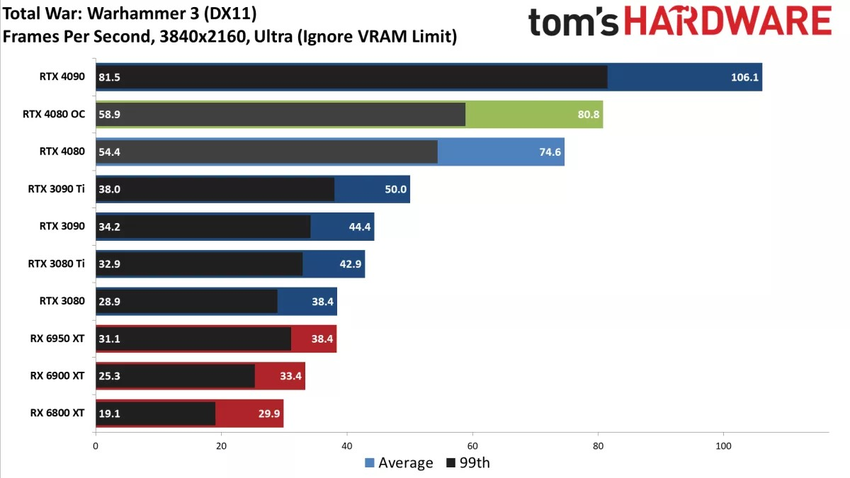

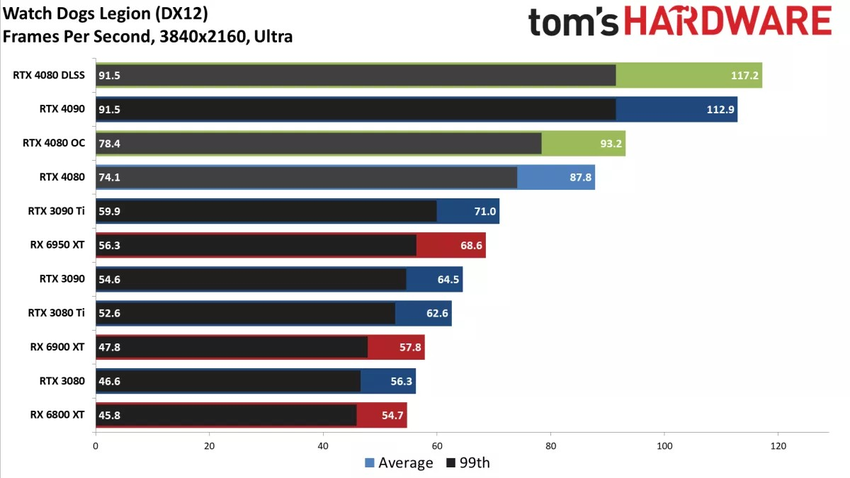

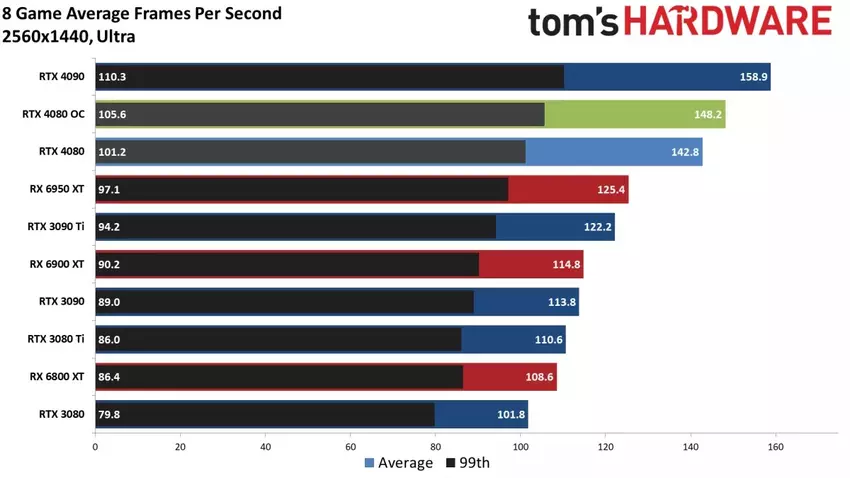

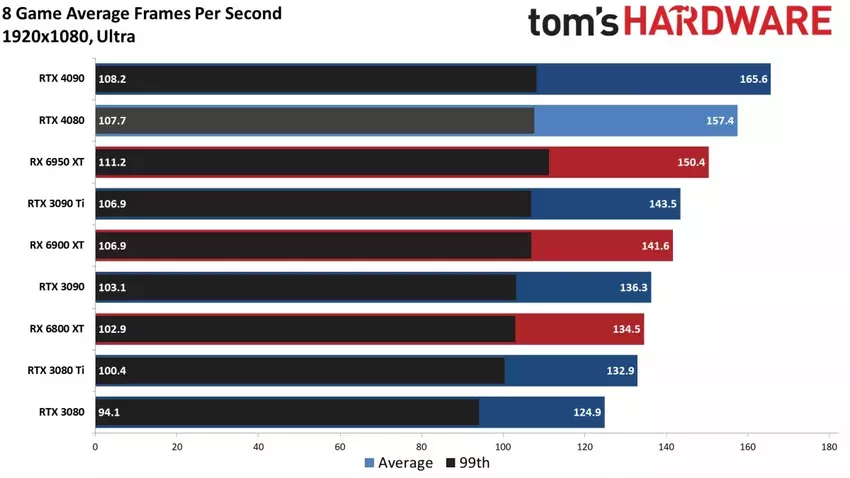

GeForce RTX 4080 nie ma szans z kartą graficzną generacji Turing. Przeciętnie przewyższa on swojego poprzednika o półtora raza w grach w rozdzielczości 4K UHD. Co więcej, GeForce RTX 4080 jest o 20% szybszy od GeForce RTX 3090 Ti, który został wyceniony na 1999 dolarów. Nasza bohaterka pozostaje w tyle za kosztującym 1599 dolarów GeForce RTX 4090 średnio o te same 20%.

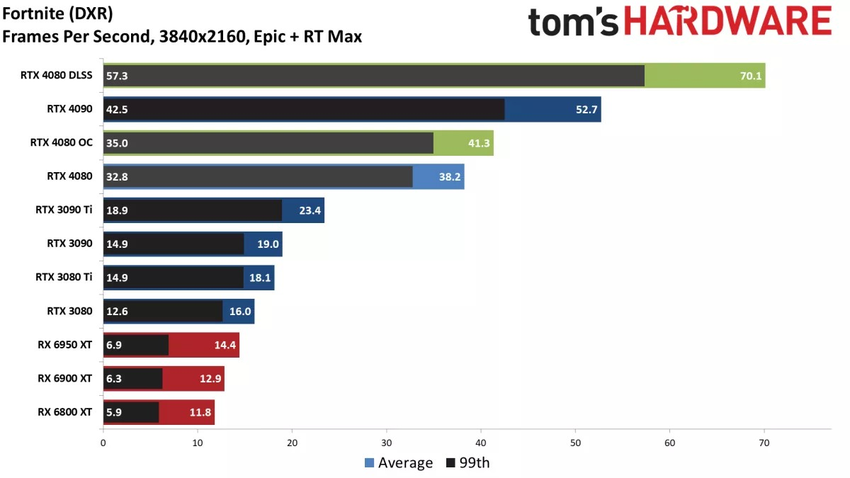

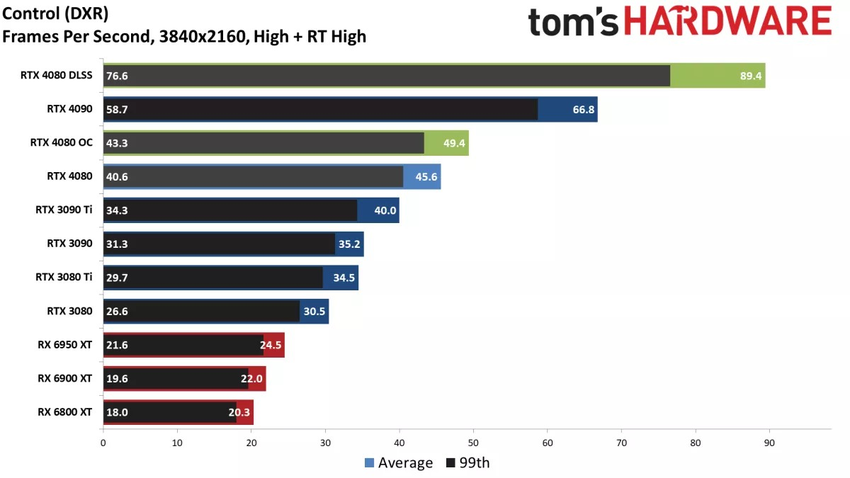

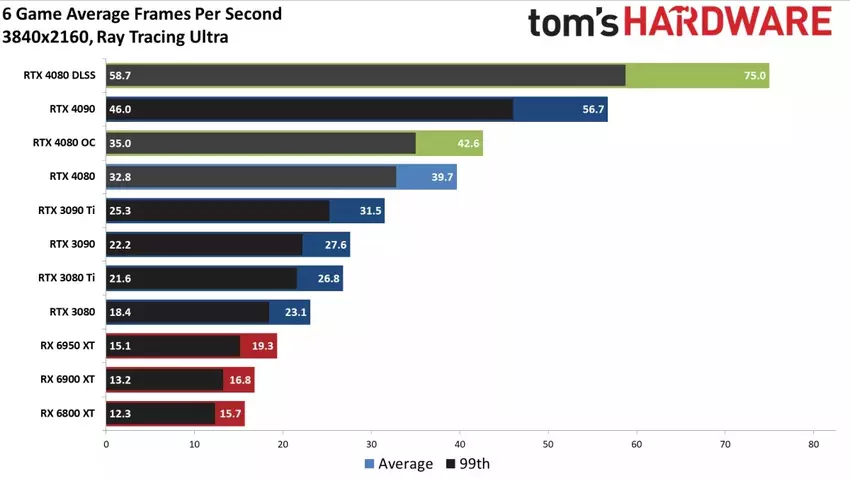

Po włączeniu ray tracingu GeForce RTX 4080 nie pozostawia szans ani GeForce RTX 3080, RTX 3090 Ti, ani Radeonowi RX 6950 XT. I to nawet bez DLSS. Po włączeniu DLSS karta graficzna bije na głowę nawet RTX 4090 (bez DLSS).

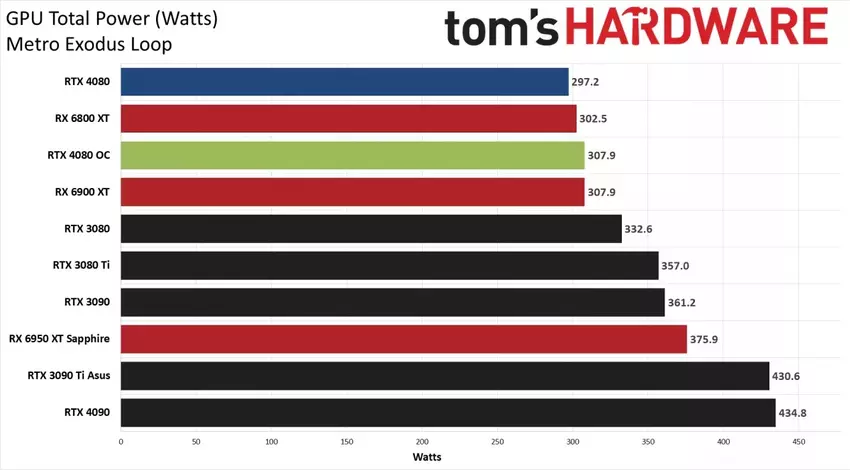

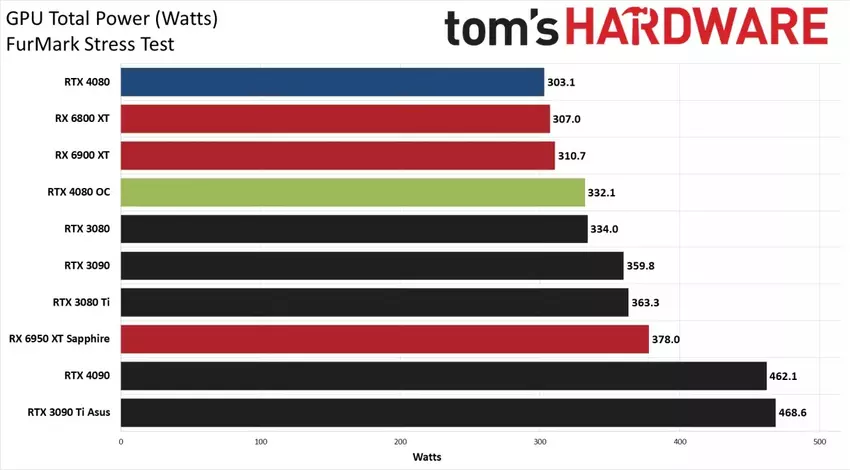

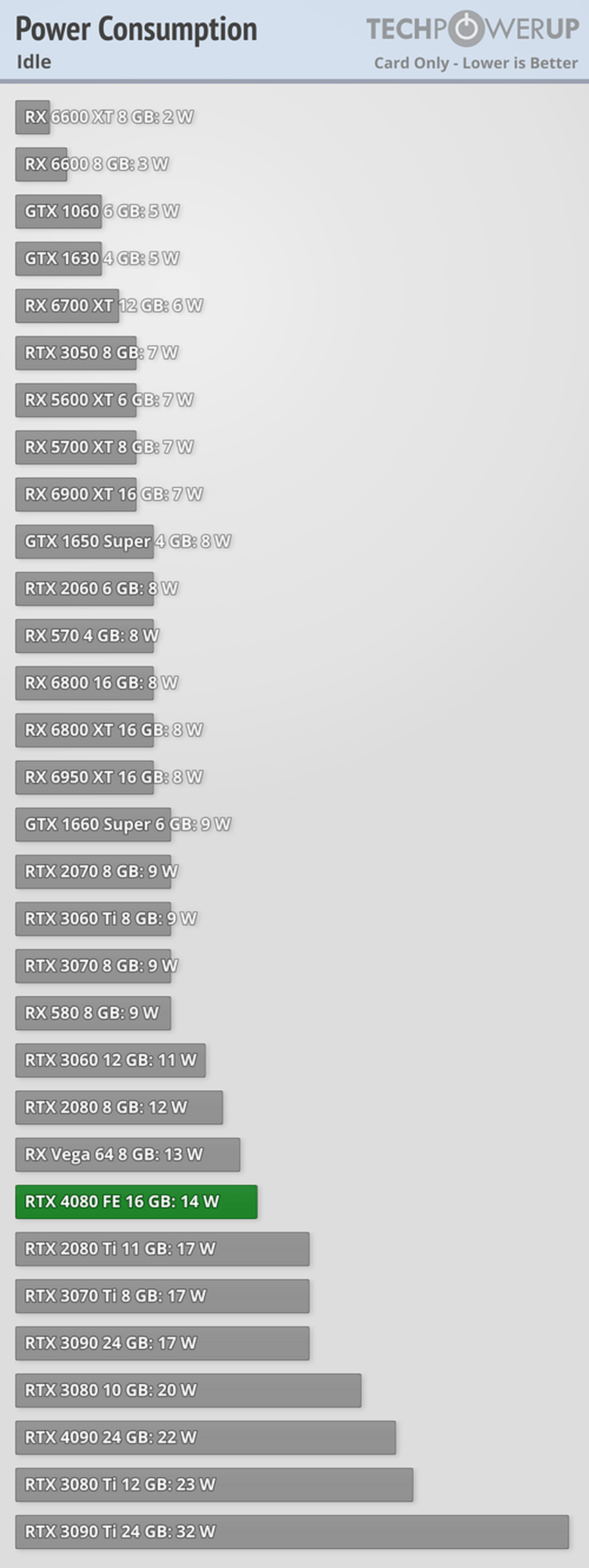

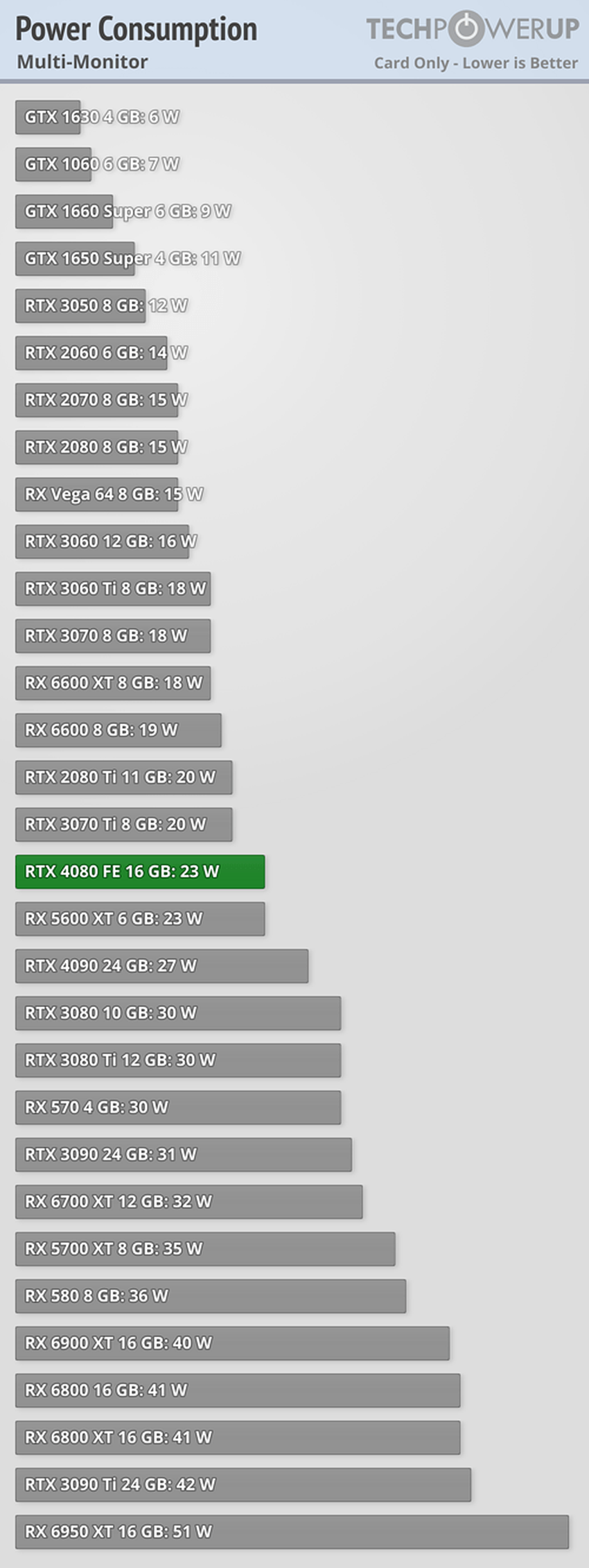

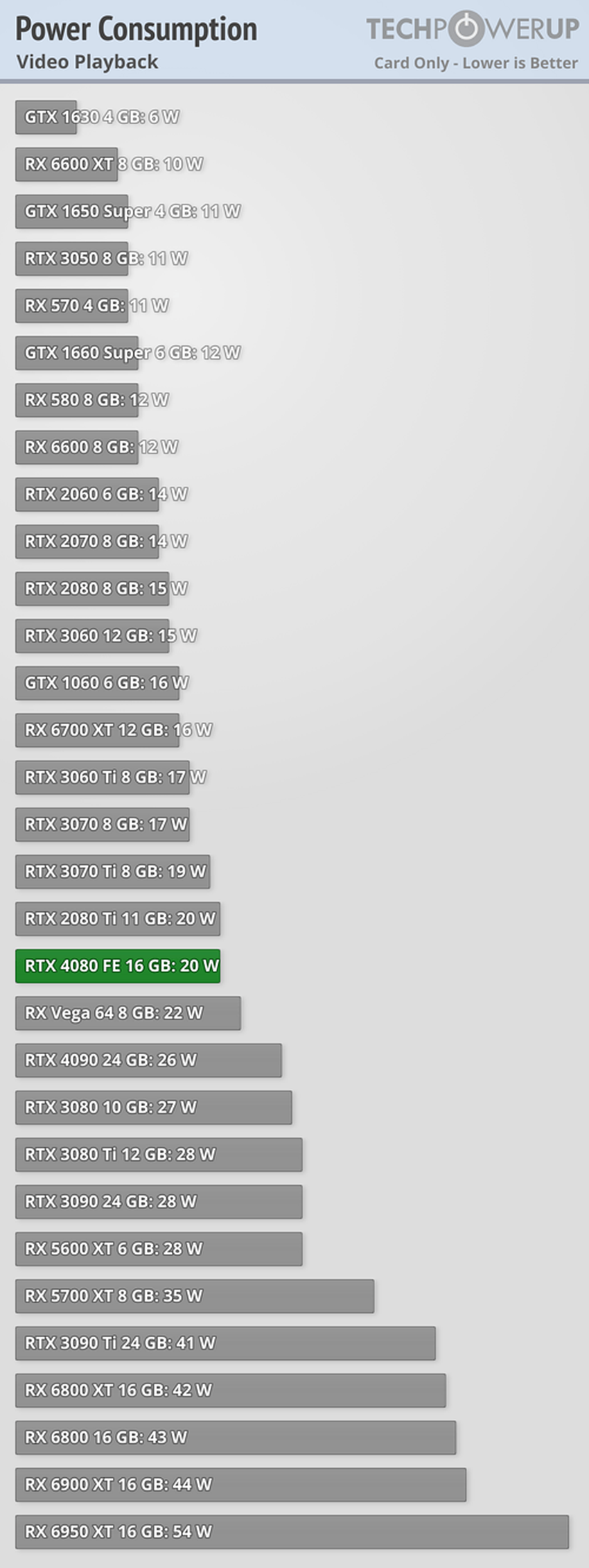

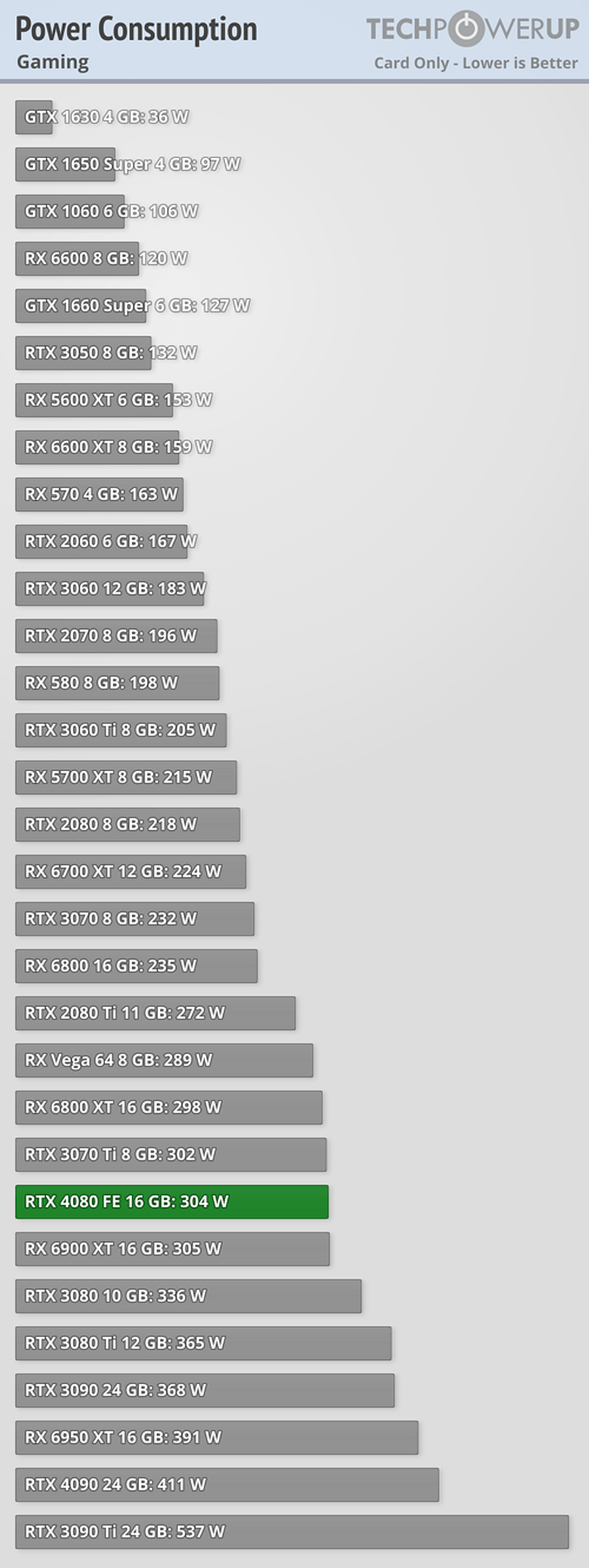

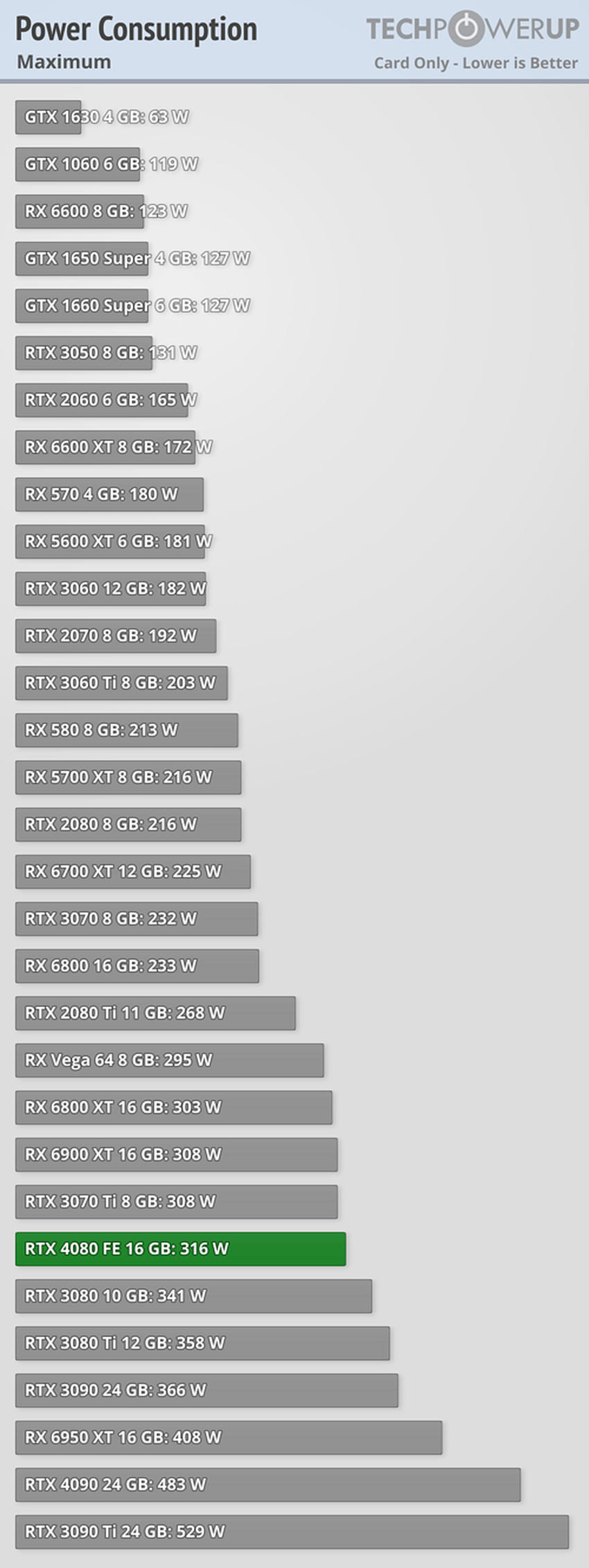

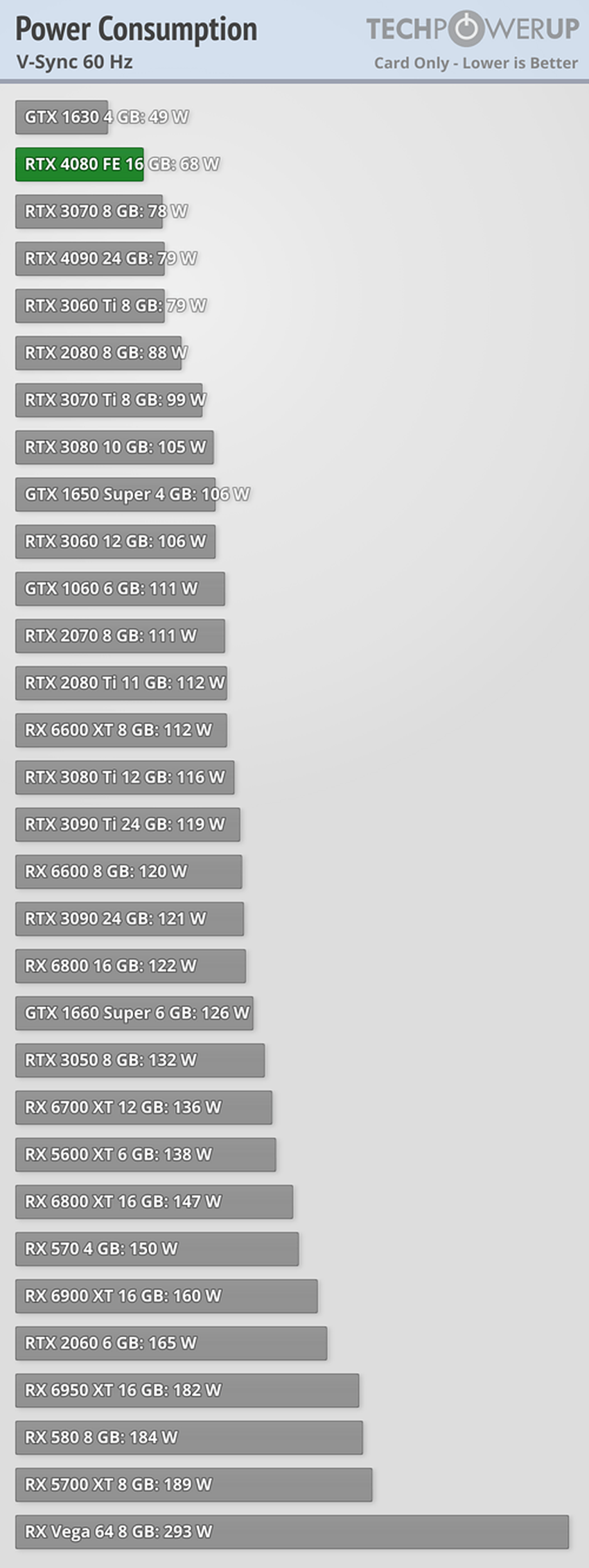

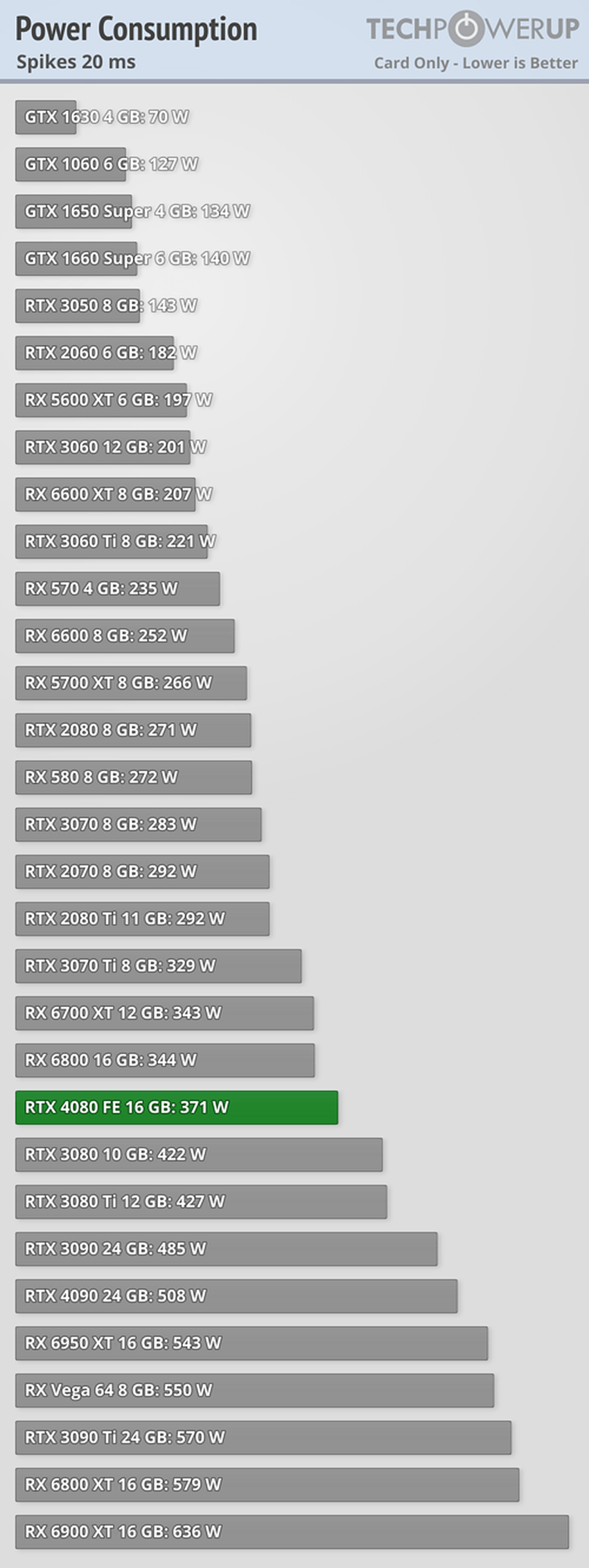

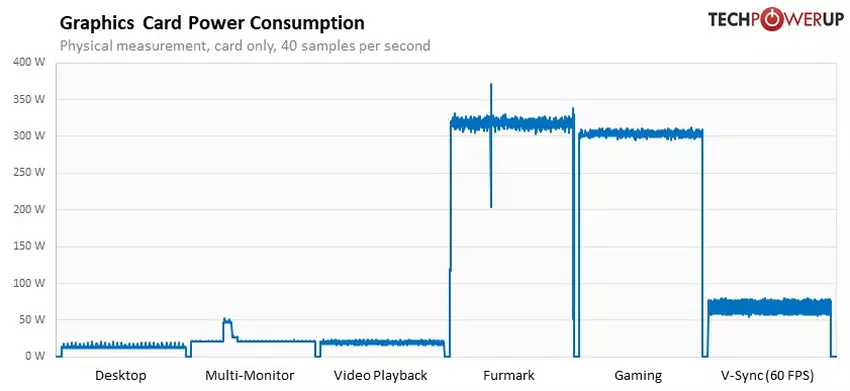

W grach i testach GeForce RTX 4080 zużywa średnio 300W. Maksymalny pobór mocy wyniósł 371W. Osobno odnotowujemy, że karta zaczęła pobierać 332,1W podczas podkręcania GPU, kiedy to częstotliwość ustabilizowała się na poziomie 2621,5 MHz przy deklarowanej maksymalnej wartości 2508 MHz.

Jednym słowem, GeForce RTX 4080 to dobre rozwiązanie dla systemów, w których znajduje się monitor 4K UHD. Pod względem wydajności na wat i na dolara, karta graficzna za 1199 dolarów bije na głowę GeForce RTX 4090. Nie zapominajmy jednak, że RTX 3080 kosztuje 699 dolarów i również oferuje wysoką wydajność.

Źródło: Tom's Hardware, TechPowerUp