Nowe narzędzie Nightshade pozwala artystom potajemnie uszkadzać dane na potrzeby szkolenia sztucznej inteligencji.

Uniwersytet w Chicago

Zespół z Uniwersytetu w Chicago opracował narzędzie o nazwie Nightshade, które daje artystom możliwość dodawania niewidocznych pikseli do dzieł, które psują dane szkoleniowe dla sztucznej inteligencji.

Co wiadomo

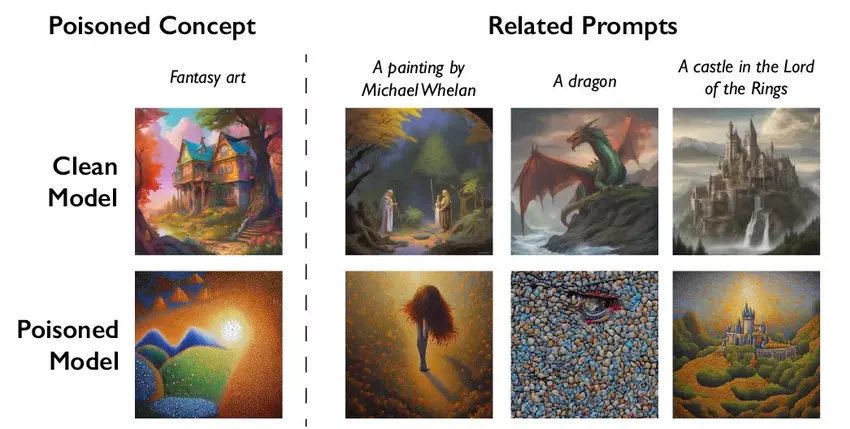

Sposób działania Nightshade polega na wstrzykiwaniu pewnego rodzaju "trucizny" do danych treningowych. Powoduje to, że sztuczna inteligencja błędnie interpretuje zapytania użytkowników i tworzy zniekształcone treści. Na przykład system może na żądanie wygenerować obraz kota zamiast psa.

Zgodnie z planem deweloperów, takie podejście powinno zachęcić firmy takie jak OpenAI, które aktywnie wykorzystują dane artystów do szkolenia sztucznej inteligencji, do ubiegania się o pozwolenie na to i płacenia odszkodowania. Aby usunąć uszkodzone dane Nightshade z próbki szkoleniowej, musieliby ręcznie wyszukać każdy taki fragment, co jest niezwykle pracochłonne.

Narzędzie jest obecnie poddawane wzajemnej weryfikacji i testom. Twórcy przetestowali jego działanie na popularnym modelu Stable Diffusion, a także na własnym eksperymentalnym modelu sztucznej inteligencji.

Według nich Nightshade nie jest panaceum, a niektórzy mogą go używać do samolubnych celów. Aby jednak wyrządzić poważne szkody w treningu sztucznej inteligencji, atakujący musieliby dodać zniekształcenia do tysięcy dzieł sztuki.

Nightshade był drugim takim narzędziem po Glaze, wydanym przez ten sam zespół w sierpniu 2022 roku. Glaze wprowadza również zmiany w obrazach niezauważone przez ludzi, chroniąc prawa autorskie artystów.

Źródło: MIT Technology Review