NVIDIA prezentuje nowy flagowy układ H200 dla sztucznej inteligencji

NVIDIA

Firma NVIDIA ogłosiła wydanie nowego topowego układu do zadań sztucznej inteligencji - H200, który zastąpi deficytowy akcelerator H100.

Co wiadomo

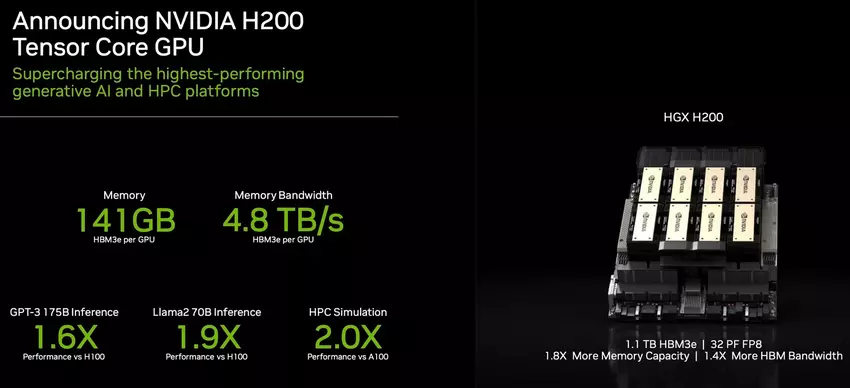

Zewnętrznie H200 nie różni się zbytnio od swojego poprzednika. Kluczowa aktualizacja dotyczy jednak pamięci - nowy układ wykorzystuje szybszą i bardziej pojemną pamięć typu HBM3e.

Dzięki temu przepustowość pamięci wzrosła do 4,8 Tbyte/s w porównaniu do 3,35 Tbyte/s w H100. Całkowita pojemność wzrosła z 80 GB do 141 GB.

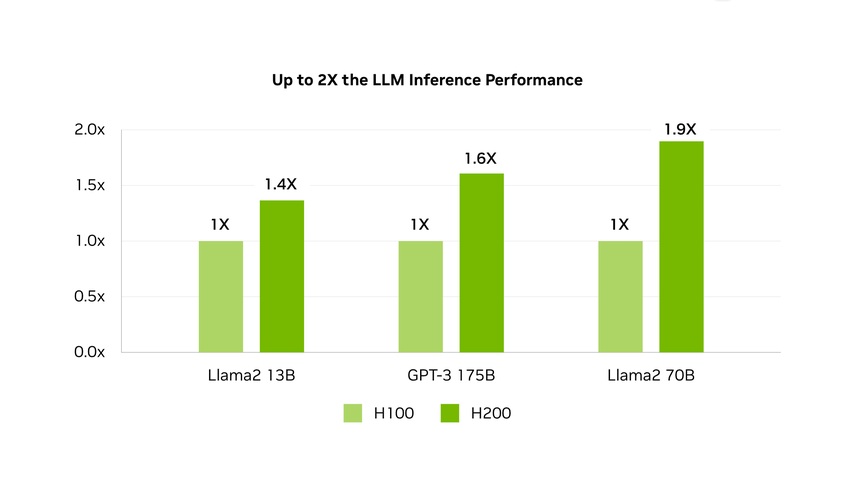

NVIDIA twierdzi, że nowy układ zapewnia prawie dwukrotny wzrost wydajności w zadaniach generatywnej sztucznej inteligencji w porównaniu do H100. Ocena opiera się na testach modeli językowych GPT-3 i Llama 2.

H200 jest w pełni kompatybilny z istniejącymi systemami obsługującymi H100. Działy chmurowe Amazon, Google, Microsoft i Oracle będą jednymi z pierwszych, które zaoferują nowe chipy swoim klientom.

Pierwsze dostawy nowych chipów spodziewane są w drugim kwartale 2024 roku. Ich koszt nie jest znany, ale według doniesień medialnych, H100 sprzedaje się za 25 000 do 40 000 USD.

Ogłoszenie pojawiło się w obliczu niedoboru chipów NVIDIA AI. W przyszłym roku firma planuje zwiększyć produkcję H100, który jest nadal poszukiwany przez programistów AI.

Źródło: NVIDIA