Apple zaprezentowało model sztucznej inteligencji do edycji obrazów na podstawie poleceń tekstowych

Laurenz Heymann/Unsplash.

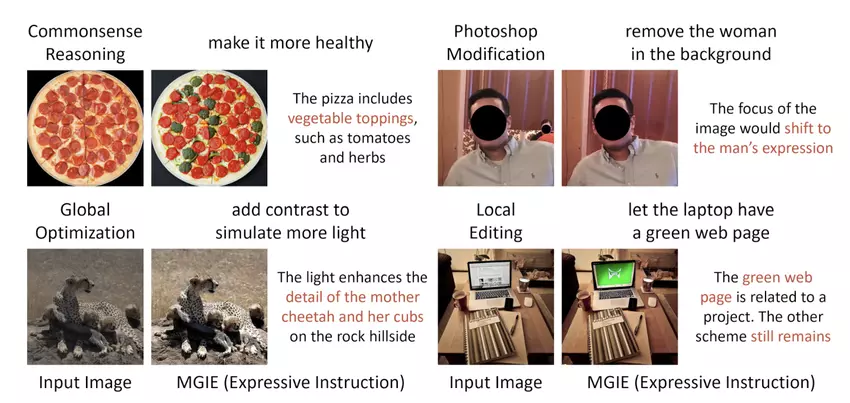

Apple, wraz z naukowcami z Uniwersytetu Kalifornijskiego, opracowało i opublikowało model sztucznej inteligencji o nazwie MLLM-Guided Image Editing (MGIE). Umożliwia on wprowadzanie zmian w obrazach na podstawie instrukcji tekstowych w języku naturalnym.

Co wiadomo

MGIE wykorzystuje technologię multimodalnych modeli dużych języków. Umożliwia to interpretację krótkich i niejednoznacznych poleceń użytkownika w celu dalszej edycji zdjęć. Na przykład, polecenie "zrób zdrowiej" dla zdjęcia pizzy AI może zrozumieć jako potrzebę dodania składników warzywnych.

Oprócz wprowadzania większych zmian w treści, model może wykonywać podstawowe operacje, takie jak przycinanie, obracanie, zmiana rozmiaru i korekcja kolorów obrazów. Sztuczna inteligencja może również przetwarzać poszczególne regiony w celu przekształcenia określonych obiektów.

MGIE jest dostępny na GitHub. Ponadto Apple opublikowało wersję demonstracyjną usługi w zasobach Hugging Face.

Nie wiadomo jeszcze, czy firma planuje zintegrować tę technologię z własnymi produktami.

Źródło: Engadget