Opera aktualizuje swoją przeglądarkę, aby dodać obsługę lokalnych modeli AI

Opera, firma aktywnie inwestująca w sztuczną inteligencję (AI), zaprezentowała nową funkcję, która umożliwia użytkownikom dostęp do lokalnych modeli AI bezpośrednio z przeglądarki.

Co wiadomo

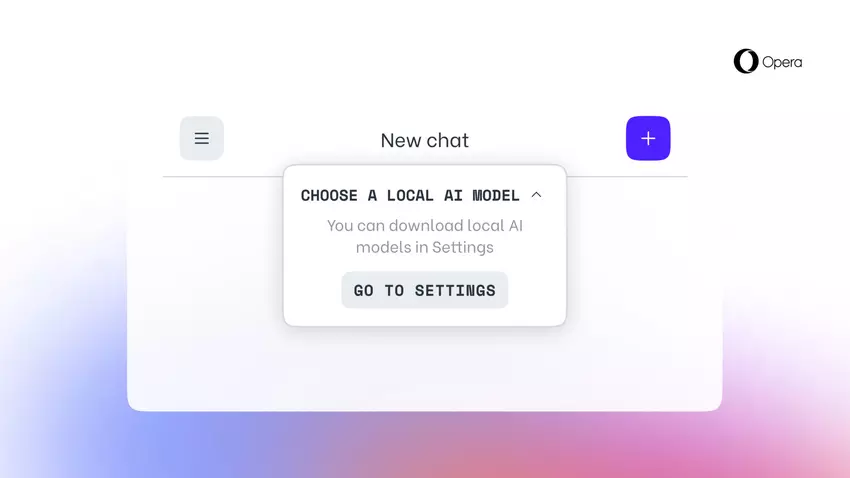

Ta opcja, której nie oferuje jeszcze żadna inna przeglądarka, jest możliwa dzięki dodaniu eksperymentalnej obsługi 150 wariantów lokalnych dużych modeli językowych (LLM) z około 50 rodzin modeli.

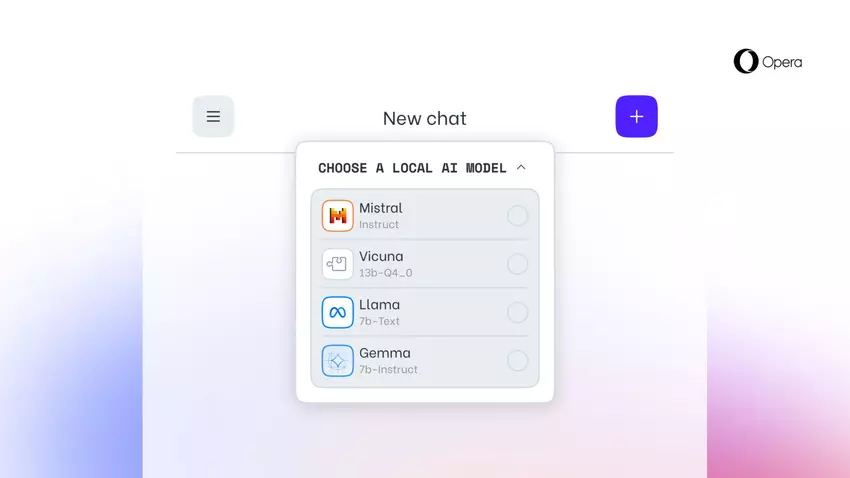

Lokalne modele AI są dodatkiem do usługi online Opera Aria AI, która jest również dostępna w przeglądarce Opera na iOS i Androida. Obsługiwane lokalne modele LLM obejmują modele takie jak Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) i wiele innych.

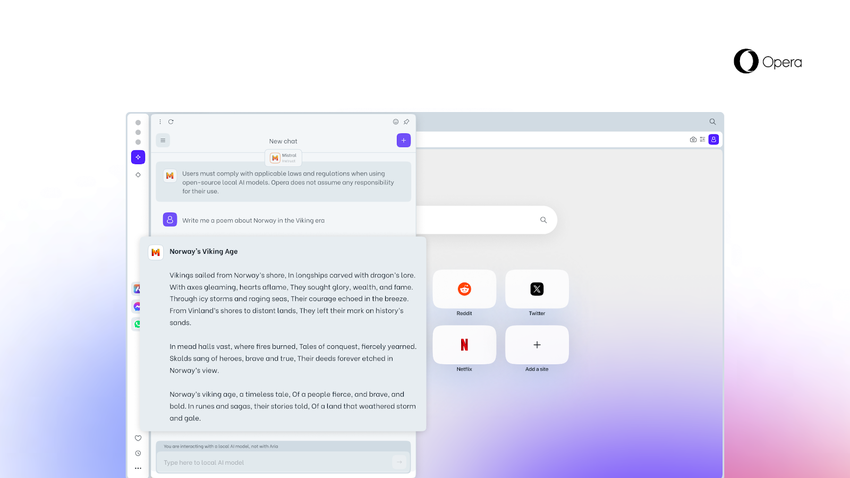

Nowa funkcja jest szczególnie ważna dla tych, którzy chcą zachować prywatność podczas przeglądania sieci. Możliwość dostępu do lokalnych LLM z Opery oznacza, że dane użytkowników są przechowywane lokalnie na ich urządzeniu, co pozwala im korzystać z generatywnej sztucznej inteligencji bez konieczności wysyłania informacji na serwer.

Od dziś nowa funkcja jest dostępna dla użytkowników Opera One Developer, choć aby ją aktywować, należy zaktualizować Operę do najnowszej wersji i postępować zgodnie z instrukcjami krok po kroku.

Warto pamiętać, że po wybraniu konkretnego LLM zostanie on pobrany na urządzenie. Ważne jest również, aby pamiętać, że lokalny LLM zazwyczaj wymaga od 2 GB do 10 GB miejsca na dysku dla każdej opcji. Po pobraniu na urządzenie, nowy LLM będzie używany zamiast Arii, wbudowanej sztucznej inteligencji przeglądarki Opera.

Źródło: Opera