Microsoft zaprezentowała Maia 200 — własny chip do AI, aby mniej zależeć od NVIDIA

Firma Microsoft oficjalnie ogłosiła Maia 200 — nowy, specjalizowany procesor do obliczeń AI, w szczególności dedykowany do inferencji, czyli uruchamiania już wytrenowanych modeli. Chip jest następcą Maia 100, który został wydany w 2023 roku, i odzwierciedla strategię Microsoftu polegającą na zmniejszeniu kosztów infrastruktury AI oraz zmniejszeniu zależności od sprzętu NVIDIA.

Co wiadomo

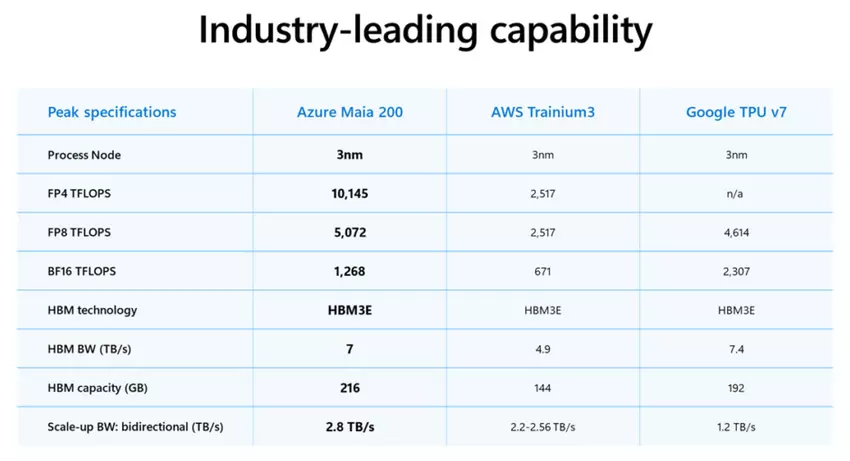

Maia 200 zawiera ponad 100 mld tranzystorów i jest zbudowany w technologii TSMC o rozmiarze 3 nm. Według Microsoftu, akcelerator zapewnia ponad 10 petaflopów wydajności przy 4-bitowej precyzji (FP4) i około 5 petaflopów przy 8-bitowej (FP8). Takie parametry umożliwiają uruchamianie największych współczesnych modeli językowych na jednym węźle z zapasem na wzrost ich złożoności.

Skoncentrowanie się właśnie na inferencji jest łatwe do wyjaśnienia: w miarę rozwoju usług AI to właśnie uruchamianie modeli, a nie ich trenowanie, staje się głównym źródłem kosztów. Microsoft liczy, że Maia 200 obniży zużycie energii i uprości wdrażanie systemów AI w centrach danych Microsoft Azure.

Firma bezpośrednio porównuje nowy model z alternatywami konkurentów. Według jej danych, Maia 200 zapewnia trzy razy wyższą wydajność FP4 niż trzecia generacja Amazon Trainium, a także przewyższa pod względem FP8 osiągi siódmej generacji Google TPU.

W praktyce Maia 200 jest już wykorzystywany wewnątrz Microsoftu — do pracy modeli działu Superintelligence i usług Copilot. Równocześnie firma otwiera dostęp do SDK dla deweloperów, badaczy i laboratoriów AI. Pierwsze wdrożenia chipa już rozpoczęły się w centrach danych w USA, a rozszerzenie na inne regiony jest planowane w najbliższym czasie.

Źródło: Microsoft