Apple udostępniło kompaktowe modele językowe OpenELM do uruchamiania na gadżetach

Mohamed M/Unsplash

Apple zaprezentowało lekkie modele językowe OpenELM, które mogą działać lokalnie na urządzeniach bez połączenia z chmurą.

Co wiadomo

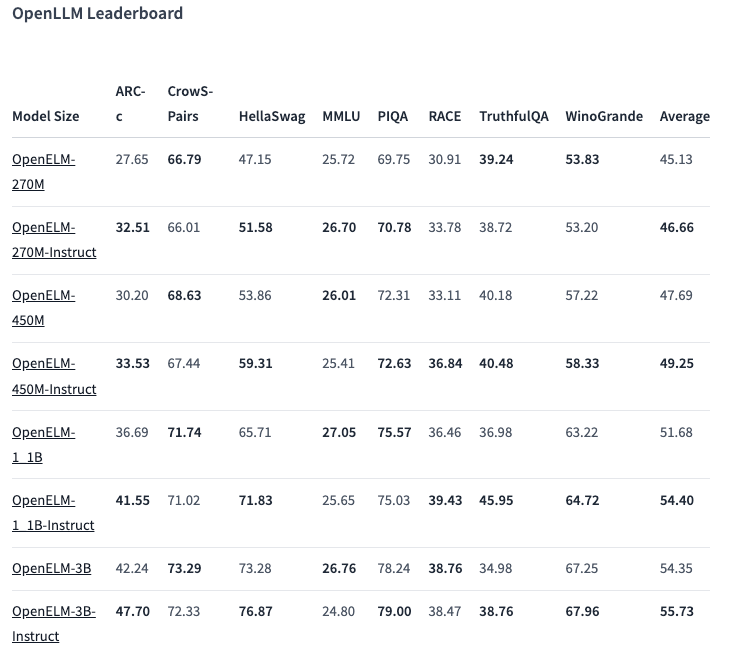

W ofercie OpenELM znajduje się osiem modeli dwóch typów - wstępnie wytrenowanych i dostosowanych przez instrukcje. Każdy wariant jest dostępny z 270 milionami, 450 milionami, 1,1 miliarda i 3 miliardami parametrów.

Modele zostały wstępnie wytrenowane na publicznych zbiorach danych zawierających 1,8 biliona tokenów z witryn takich jak Reddit, Wikipedia, arXiv.org i innych.

Dzięki optymalizacjom, OpenELM mogą działać na zwykłych laptopach, a nawet niektórych smartfonach. Testy przeprowadzono na komputerach z procesorami Intel i9 i RTX 4090, a także na MacBooku Pro M2 Max.

Według Apple modele te wykazują dobrą wydajność. Szczególnie wyróżnia się wariant z instrukcjami o wartości 450 milionów parametrów. A OpenELM-1.1B przewyższył swój odpowiednik GPT OLMo o 2,36%, wymagając jednocześnie o połowę mniej tokenów do wstępnego szkolenia

W teście porównawczym ARC-C, zaprojektowanym do testowania wiedzy i umiejętności rozumowania, wstępnie wytrenowany wariant OpenELM-3B wykazał dokładność 42,24%. Natomiast w testach MMLU i HellaSwag uzyskał odpowiednio 26,76% i 73,28%.

Firma opublikowała kod źródłowy OpenELM na Hugging Face na otwartej licencji, w tym wytrenowane wersje, testy porównawcze i instrukcje modelu.

Apple ostrzega jednak, że OpenELM może generować nieprawidłowe, szkodliwe lub nieodpowiednie odpowiedzi ze względu na brak zabezpieczeń.

Źródło: VentureBeat