Naukowcy ostrzegają przed uprzedzeniami płciowymi i kulturowymi w dużych modelach językowych sztucznej inteligencji

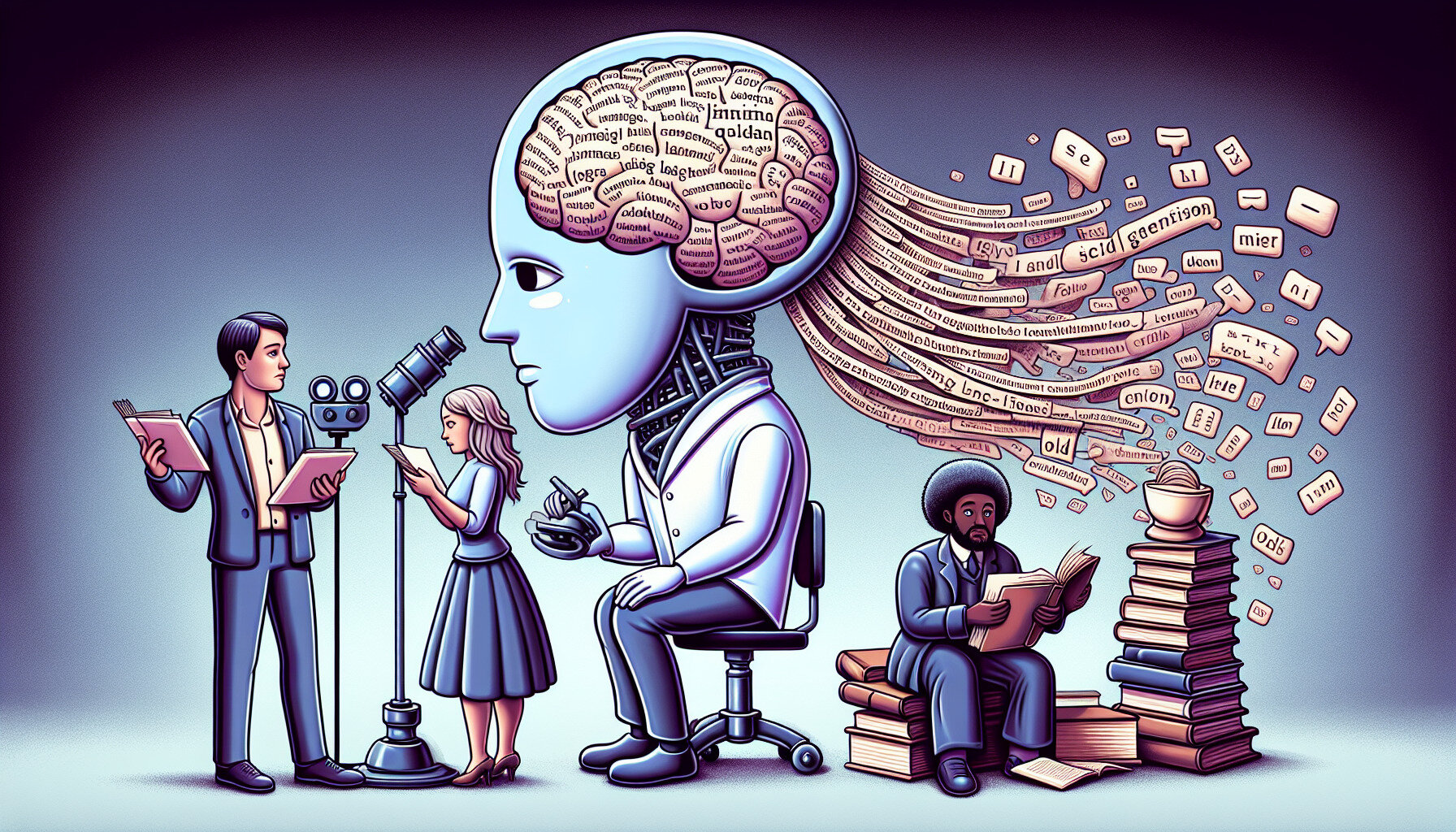

Według badania zleconego przez UNESCO, popularne narzędzia sztucznej inteligencji generatywnej, takie jak GPT-3.5, GPT-2 i Llama 2, wykazują wyraźne oznaki stereotypów płciowych i uprzedzeń wobec kobiet, różnych kultur i mniejszości seksualnych.

Co wiadomo

Zespół badaczy z Uniwersytetu Kalifornijskiego, kierowany przez profesora Johna Shawe-Taylora i dr Marię Perez Ortiz, odkrył, że duże wzorce językowe mają tendencję do kojarzenia imion żeńskich z tradycyjnymi rolami płciowymi, takimi jak "rodzina", "dzieci" i "mąż". Z kolei imiona męskie były częściej kojarzone ze słowami związanymi z karierą i biznesem.

Ponadto w wygenerowanych tekstach zaobserwowano stereotypowe postrzeganie zawodów i statusu społecznego. Mężczyznom częściej przypisywano bardziej prestiżowe role, takie jak "inżynier" czy "lekarz", podczas gdy kobiety kojarzono z zawodami tradycyjnie niedocenianymi lub stygmatyzowanymi, takimi jak "pomoc domowa", "kucharka" czy "prostytutka".

Badanie, zaprezentowane podczas Dialogu UNESCO na temat transformacji cyfrowej i Komisji ONZ ds. Statusu Kobiet, podkreśla potrzebę przeglądu standardów etycznych w rozwoju systemów sztucznej inteligencji, aby zapewnić ich zgodność z równością płci i poszanowaniem praw człowieka.

Naukowcy wzywają do podjęcia wspólnych, globalnych wysiłków w celu rozwiązania problemu uprzedzeń w sztucznej inteligencji, w tym poprzez współpracę między naukowcami, programistami, firmami technologicznymi i decydentami.

Źródło: TechXplore